Secciones

Servicios

Destacamos

Los bulos no son nada nuevo. Siempre han estado ahí, incluso en los periódicos, como aquella serie de noticias falsas sobre habitantes de la Luna que el diario neoyorquino The Sun publicó en 1835 («Great Moon Hoax»). Pero en los últimos años, potenciados ... sobre todo por la inteligencia artificial (IA), los contenidos falsos superan la capacidad de detectarlos. La consultora Gartner estableció hace tres años que para 2022 la mitad de noticias que circularan por la red serían falsas. Palabras como censura, verificación o bots están a la orden del día. Y entre tanta desinformación, es necesario arrojar algo de luz para comprender qué está ocurriendo.

El estudio que el grupo de investigación Digilab de la Universidad Blanquerna de Barcelona publicó la semana pasada recoge que el 73,5% de las personas encuestadas comprueba las noticias falsas, al menos las que le interesan. Los medios de comunicación aparecen como vacuna contra los bulos, ya que son la segunda vía utilizada, detrás de Google, mientras que los sistemas de comprobación (fact checkers) son utilizados sólo por el 10%.

«Newtral y Maldita censurarán los mensajes de WhatsApp y Facebook», era la conclusión a la que llegaban decenas de usuarios de redes sociales estos días. De hecho, el rumor ha generado un traslado masivo a la aplicación de mensajería Telegram. Pero no es, del todo, cierto.

Facebook sufrió un duro golpe cuando en las últimas elecciones de Estados Unidos se destapó que varios de sus trabajadores cuya función era verificar noticias habían filtrado las que ideológicamente más les interesaban. Esto, unido a las campañas con anuncios falsos, hizo que la red social de Mark Zuckerberg buscara la forma de solventarlo y se dio cuenta de que dejarlo en manos de la inteligencia artificial tampoco funcionaba.

Así, en 2019, coincidiendo con el año electoral, se vincularon a Facebook España como verificadores la agencia AFP, Newtral y Maldita (miembros de la International Fact-Cheking Network), que se unían al elenco de 43 socios internacionales. Su trabajo en la red social era la revisión de contenido para determinar si era falso o no, de forma proactiva, y en el caso de serlo, reducir su distribución hasta en un 80%.

Estos días, el problema para Facebook, propietaria de WhatsApp desde 2014, ha explotado de nuevo por dos motivos: la censura de un artículo del medio Vozpópuli en Facebook y el cambio de normativa de WhatsApp sobre el envío de mensajes.

El primero, según indica Marcos Sierra, periodista del medio, les pilló por sorpresa y no han obtenido solución. El 13 de abril publicaron una información en la que explicaban qué empresas de verificación trabajan con Facebook en España, y la red social, por petición de Maldita, borró el artículo al ser calificado como «noticia falsa». Ante la solicitud de información a la red social por lo ocurrido, esta les remitió a las empresas verificadoras para que negociaran con ellas los cambios, como establece su protocolo.

No hay que olvidar que es una empresa privada (Facebook) la que solicita a otra empresa privada (verificadores) la gestión de su red, algo lícito, pero impensable para muchos por la cantidad de datos que manejan e indecente si afecta a la libertad informativa de medios. Aun así, como se suele decir, es su juego y son sus reglas. Ahora bien, uno de sus cometidos es mostrar contenido veraz a los usuarios que han compartido un bulo, por lo que determinar qué noticias llegarán a los usuarios, otorga notable poder.

Por otra parte está el tema de WhatsApp, donde los verificadores no deciden qué contenido se puede compartir y cuál no. En la plataforma de mensajería actúan de forma reactiva, recibiendo mensajes de los usuarios y contestando a estos con información sobre si lo que les han enviado es un bulo o no. Es decir, no filtran, sino que responden a los usuarios que les preguntan.

La duda se ha suscitado cuando Facebook ha decidido, con el objetivo de evitar la propagación masiva de bulos, limitar el reenvío masivo de mensajes, tanto en España como en el resto del mundo. Una decisión acertada que nos recuerda a los filtros antispam del correo electrónico (determinados mails, seleccionados por su temática o remitente, van directos a la papelera). El cifrado de los mensajes de WhatsApp hace que la plataforma no conozca el contenido exacto de lo que se envía, por lo que no, en este aspecto no se ejerce censura, sino que se limita la propagación de material ajeno. Si estamos interesados en enviar un mensaje propio a 20 personas podemos seguir haciéndolo, pero de cinco en cinco.

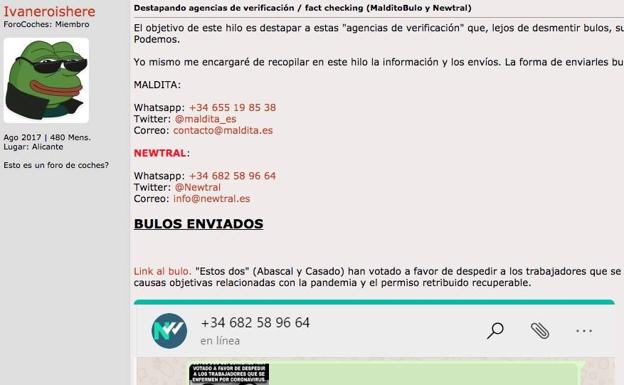

La llegada de estos cambios coincide con la crítica hacia la ideología de Newtral o Maldita, que alega que se decantan más por desmentir bulos de partidos de derechas, aunque en las condiciones del servicio de Facebook se establece que se «promueve una verificación no partidista». En Forocoches, el foro de habla hispana más visitado, y por ende uno de los lugares con más trols (prueba de ello son sus intervenciones en concursos y acciones masivas), hay un hilo abierto por el usuario Ivaneroishere donde mediante capturas de pantalla trata de demostrar que estos verificadores «favorecen una corriente y sesgo ideológico».

No se puede obviar en este sentido que el director de contenidos de Newtral es Joaquín Ortega, asesor del PSOE en 2010-2012, que la empresa, con Ana Pastor como única accionista, es productora de La Sexta, y que los fundadores de Maldita, Clara Jiménez y Julio Montes, fueron periodistas de este medio.

Dejando al margen la corriente ideológica, que conviene conocer pero que en mayor o menor medida todo el mundo posee, Newtral es una empresa privada, Maldita una organización sin ánimo de lucro y AFP una agencia de noticias. A estas tres se ha unido recientemente la agencia EFE como verificadora de contenido para Facebook y WhatsApp.

Pero el mayor control de los contenidos no es solo una preocupación de Facebook, sino también del gobierno español. José Manuel Gallego, general jefe del Estado Mayor, explicaba el pasado 15 de abril en una rueda de prensa que la Guardia Civil, además de combatir bulos, se dedicaba a «minimizar el clima contrario a la gestión de crisis por parte del Gobierno». Una frase lapidaria que pone de manifiesto, según se entiende, que la Jefatura de Información se dedica, además de desmentir bulos, a perseguir aquellos contenidos que generan un clima de disconformidad con el Gobierno.

Lo primero es necesario, como hemos ido viendo, pero englobando todas las ideologías. Lo segundo atenta directamente contra el artículo 19 de la Declaración Universal de los Derechos Humanos, es decir, la libertad de expresión que permite manifestar ideas de todo tipo.

El ministro del Interior, Fernando Grande-Marlaska, explicó días después que se trató de un «lapsus» por parte del general al contestar, que no se refería a ningún tipo de crítica hacia el Gobierno, sino a bulos. La Guardia Civil emitió un comunicado en el que explicaba que el trabajo al que hacían alusión era el de «detectar aquellos bulos y desinformaciones que generan un gran nivel de estrés y alarma social». Aun así, la tensión, propiciada por la crisis del coronavirus, sigue en el ambiente: el Gobierno da a entender que se ha autoproclamado juez, jurado y verdugo a la hora de determinar qué es un bulo o desinformación y qué no.

Asimismo, la cadena Ser adelantaba una información en la que explicaba que la jefatura de la Guardia Civil había enviado el pasado día 15 a las comandancias (de ahí el «lapsus») una orden para identificar noticias falsas o desinformaciones «susceptibles de provocar estrés social y desafección a instituciones del Gobierno». La Unidad de Coordinación de Ciberseguridad, encargada de elaborar el informe, describe el concepto de desinformación como: «Conjunto de publicaciones en Internet, principalmente en redes sociales, de noticias falsas, medias verdades o información altamente subjetiva presentada como objetiva, con una finalidad desestabilizadora, de polarización de la opinión pública en asuntos de interés general, o de estrés social, quebrando la confianza en los poderes y representantes públicos».

Ya lo decía el poeta romano Juvenal, «Quis custodiet ipsos custodes?» («¿Quién vigila a los vigilantes?»). La delgada línea que existe entre censurar un contenido que no gusta (no olvidemos el silencio impuesto por Sanidad a sus profesionales) y catalogarlo como información altamente subjetiva o «fake news» está más cerca del Ministerio de la Verdad de Orwell que de una democracia.

*Jon Sedano es miembro del proyecto «Desinformación, Transparencia y Ciberseguridad en la práctica del periodismo», de la Universidad de Málaga.

¿Ya eres suscriptor/a? Inicia sesión

Publicidad

Publicidad

Te puede interesar

Fallece un hombre tras caer al río con su tractor en un pueblo de Segovia

El Norte de Castilla

Publicidad

Publicidad

Esta funcionalidad es exclusiva para suscriptores.

Reporta un error en esta noticia

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.